Von Benjamin Altmiks

ChatGPT hat sich längst in den Arbeitsalltag eines Großteils der Computer-nutzenden Bevölkerung integriert – und das weit über die Tech-Branche hinaus. Doch trotz des Erfolgs bleiben zentrale Kritikpunkte bestehen, allen voran der enorme Ressourcenverbrauch.

Die Neue Zürcher Zeitung berichtet, dass eine einzelne ChatGPT-Anfrage bis zu 30-mal mehr Strom verbraucht als eine Google-Suche.

Ein neues Sprachmodell, das dank effizienterer Berechnungen weniger Chips benötigt und dadurch den Energieverbrauch senkt, wäre daher zweifellos ein bedeutender Fortschritt. Die Argumentation hinter DeepSeek stützt sich genau darauf: eine ressourcenschonendere Algorithmenbasis als rein technische Verbesserung.

Doch was, wenn dieser vermeintliche Durchbruch gar nicht so innovativ ist – sondern größtenteils nur abgeschaut oder gar kopiert wurde?

Genau dieser Verdacht steht nun im Raum – erhoben von OpenAI selbst. Wie die Financial Times berichtet, behauptet das Unternehmen, Beweise dafür zu haben, dass Chinas DeepSeek sein Modell genutzt hat, um einen eigenen KI-Wettbewerber zu trainieren.

Doch was genau bedeutet das? Der Vorwurf dreht sich um Model Theft – also den Diebstahl eines bereits trainierten Machine-Learning-Modells. Diese Bedrohung ist nicht neu: Bereits 2023 stufte OWASP sie sowohl unter die Top 10 Risiken für Large Language Models (LLMs) als auch unter die Top 10 allgemeinen Machine-Learning-Risiken ein.

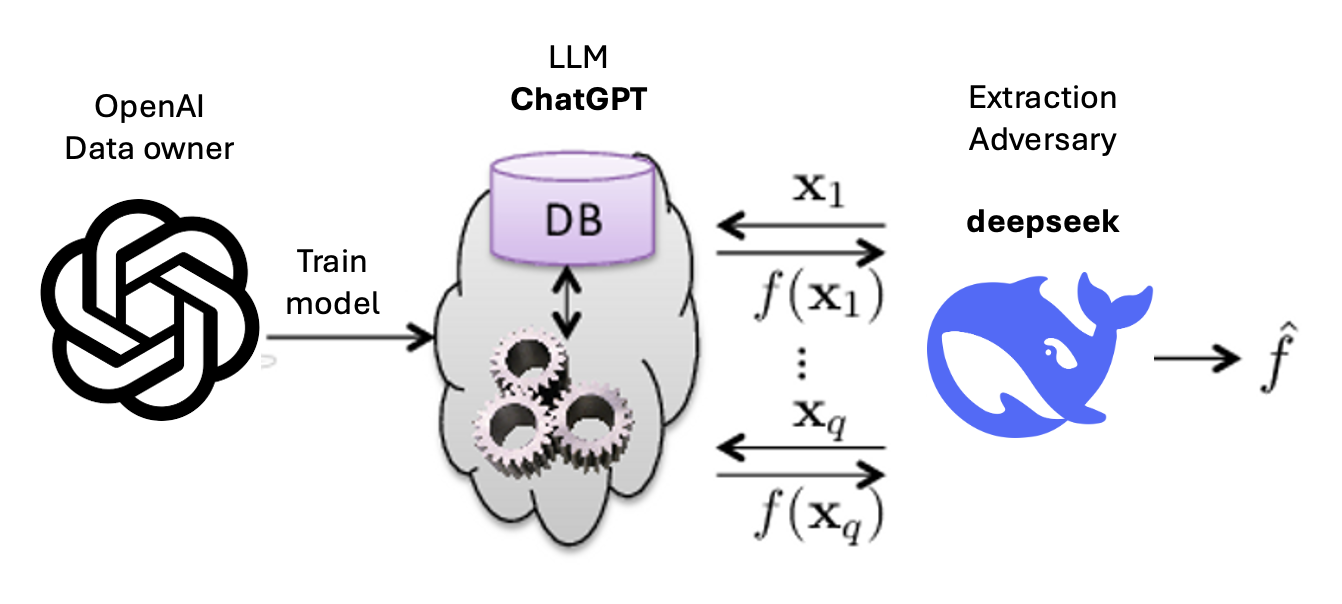

Die Methode dahinter ist ebenso simpel wie effektiv: Eine enorme Anzahl gezielter Anfragen wird an ein bestehendes Modell gesendet – in diesem Fall ChatGPT. Die generierten Antworten dienen dann als Trainingsdaten für ein neues Modell, das auf diesem Wissen aufbaut. So soll DeepSeek sich einen entscheidenden Vorteil verschafft haben – wie die folgende Grafik veranschaulicht:

Die folgende Abbildung basiert auf Tramèr et al. (2016), wurde jedoch angepasst und erweitert.

In der dargestellten Grafik wird OpenAI als Data Owner bezeichnet, obwohl ChatGPT größtenteils auf öffentlich zugänglichen Daten trainiert wurde. Dies wirft eine grundlegende ethische Frage auf: Sollten Ergebnisse, die aus öffentlichen Daten generiert wurden, nicht ebenfalls frei verfügbar und für die Allgemeinheit nutzbar sein? Gleichzeitig darf jedoch nicht außer Acht gelassen werden, dass OpenAI erhebliche Ressourcen – sowohl in Form der Datenaufbereitung und Klassifizierung als auch finanzieller Investitionen – in die Entwicklung des Modells gesteckt hat. Diese Arbeit muss geschützt werden, weshalb es nicht ohne Weiteres akzeptabel wäre, wenn DeepSeek ein Modell veröffentlicht, das auf ChatGPT basiert.

Welche Daten DeepSeek letztendlich für das Training verwendet hat, weiß jedoch nur das Unternehmen selbst. Unabhängig davon bleibt der technische Ansatz sowohl beeindruckend als auch beunruhigend. Selbst wenn das Modell lediglich eine gelungene Nachbildung von ChatGPT sein sollte, stellt dies einen beachtlichen technologischen Fortschritt dar – schließlich ist es bislang keinem anderen Unternehmen gelungen, auf dieser Basis ein konkurrenzfähiges Modell in vergleichbarer Qualität zu entwickeln.

Für Unternehmen, die eigene Sprachmodelle mit firmeninternen Daten trainieren, wird in Zukunft erhöhte Vorsicht geboten. Denn auch diese Modelle könnten potenziell kopiert und in anderen Unternehmen zweckentfremdet werden. Ob es sich um Microsoft handelt, dessen Marktstrategie besser vorhergesagt werden soll, oder um ein mittelständisches Unternehmen, dessen interne Prozesse und strategische Entscheidungen durch solche Modelle rekonstruiert werden könnten – Sprachmodelle müssen als wertvolle Assets betrachtet und entsprechend geschützt werden.

Wie sich Sprachmodelle und andere Machine-Learning-Systeme strategisch und langfristig absichern lassen, zeigen wir Ihnen bei secureIO. Buchen Sie jetzt ein Webinar, einen Vortrag oder eine praxisnahe Schulung direkt in Ihrem Unternehmen.